Die Geschwindigkeit bei der lokalen Ausführung großer Sprachmodelle (LLMs) wird in Zukunft zu einem entscheidenden Kriterium für die CPU/GPU-Auswahl werden. Das gilt insbesondere für Software-Entwickler, die LLMs lokal nutzen möchten anstatt alle Daten an Anbieter wie ChatGPT in die Cloud zu übertragen.

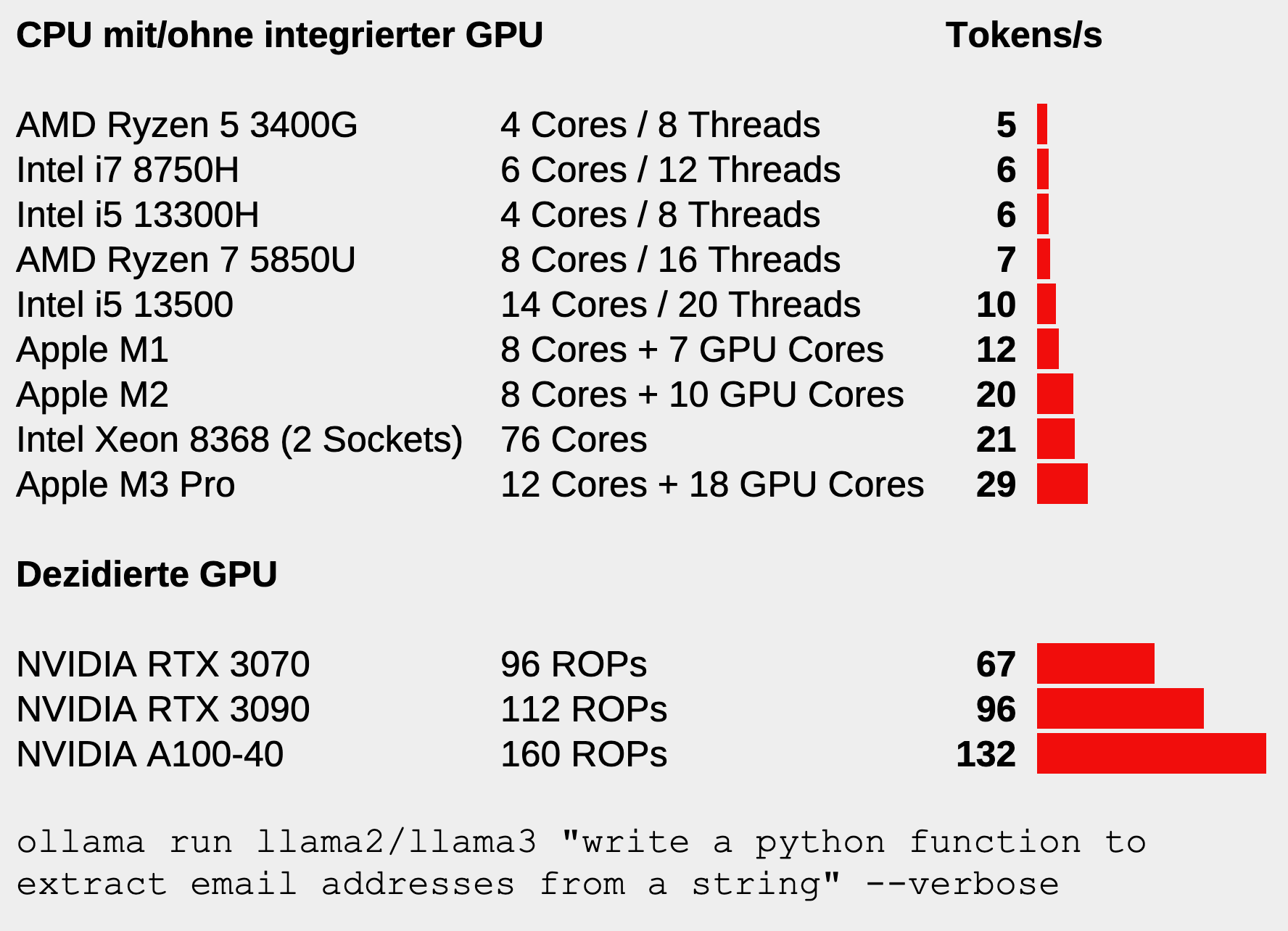

Umso verblüffender ist es, dass es dafür aktuell kaum brauchbare Benchmarks gibt. In Anknüpfung an meinen Artikel Sprachmodelle lokal ausführen und mit Hilfe des Forum-Feedbacks habe ich die folgende Abbildung zusammengestellt.

Die Geschwindigkeit in Token/s wird — zugegeben unwissenschaftlich — mit der Ausführung des folgenden Kommandos ermittelt:

ollama run llama2 "write a python function to extract email addresses from a string" --verbose

oder

ollama run llama3 "write a python function to extract email addresses from a string" --verbose

Bei den Tests ist llama3 um ca. 10 Prozent langsamer als llama2, liefert also etwas weniger Token/s. Das liegt ganz einfach daran, dass das Sprachmodell llama3 etwas größer ist als llama2 (7 versus 8 Mrd. Parameter). Die Größenordnung der Ergebnisse bleibt aber vergleichbar.

Helfen Sie mit! Wenn Sie Ollama lokal installiert haben, posten Sie bitte Ihre Ergebnisse zusammen mit den Hardware-Eckdaten im Forum. Verwenden Sie als Sprachmodell llama2 bzw. llama3 in der Defaultgröße (also mit 7 bzw. 8 Mrd. Parameter, entspricht llama2:7b oder llama3:8b). Das Sprachmodell ist dann ca. 4 bzw. 5 GByte groß, d.h. die Speicheranforderungen sind gering. (Falls Sie das LLM mit einer dezidierten GPU ausführen, muss diese einen ausreichend großen Speicher haben, in dem das ganze Sprachmodell Platz findet. Je nach Betriebssystem sind u.U. zusätzliche Treiber notwendig, damit die GPU überhaupt genutzt wird.)

Ich werde das Diagramm gelegentlich mit neuen Daten aktualisieren.

Einschränkungen

Die im Diagramm angegebenen Werte können variieren, je nach installierten Treiber, Stromversorgung, Kühlung (speziell bei Notebooks) etc.

Die Token-Geschwindigkeit wird immer kleiner, je größer der Kontext ist. Bei diesem Beispiel besteht der Kontext nur aus dem Prompt. In der Praxis ist der Prompt meist länger, das Sprachmodell muss auch beigefügte Code- oder Text-Dateien verarbeiten oder den Verlauf einer längeren Konversation berücksichtigen.

Ich berücksichtige hier nur Output-Token, also das Generieren der Antwort. Je größer der Kontext und desto länger der Prompt, desto mehr fließt auch die Verarbeitung der Input-Token in die Gesamtantwortzeit ein.

See also Ollama benchmark tool: https://llm.aidatatools.com/results-windows.php?sort=false

Thanks, great!